L'Éclipse de l'Intuition : Pourquoi l'IA a déjà gagné la bataille du savoir

Le tableau "Faits – Déductions – Conclusions" est souvent perçu comme une pesanteur et c'est une erreur, car il permet la transformation des intuitions en démonstrations rationnelles, dans une utilisation a posteriori pour justifier les choix, et non a priori, pour trouver les idées et guider la conception d'un plan (cette utilisation mène rapidement à l’impasse, du moins, pour l’humain). Le processus repose sur les trois moteurs de la création du savoir : l'induction (repérer des faits répétitifs pour en extraire une règle), la déduction (confronter cette règle à un fait nouveau) et l'analogie (point essentiel trop souvent ignoré : un fait seul ne produit jamais de déduction…). Le syllogisme, monument de l'art déductif, y trouve toute sa place : tous les ports à quai unique créent des goulots d'étranglement. Le port de Martyria n'a qu'un seul quai. Donc ce port sera un problème logistique.

Élégant. Rigoureux. Et pourtant, terriblement limité. Car ce raisonnement exige une identification préalable par l'humain de la bonne règle parmi des milliers, et le repérage des “bons” faits dans un océan de données. On crée du savoir à la bougie, en reliant péniblement deux points dans l'obscurité.

Le LLM, lui, joue dans une autre dimension. Littéralement.

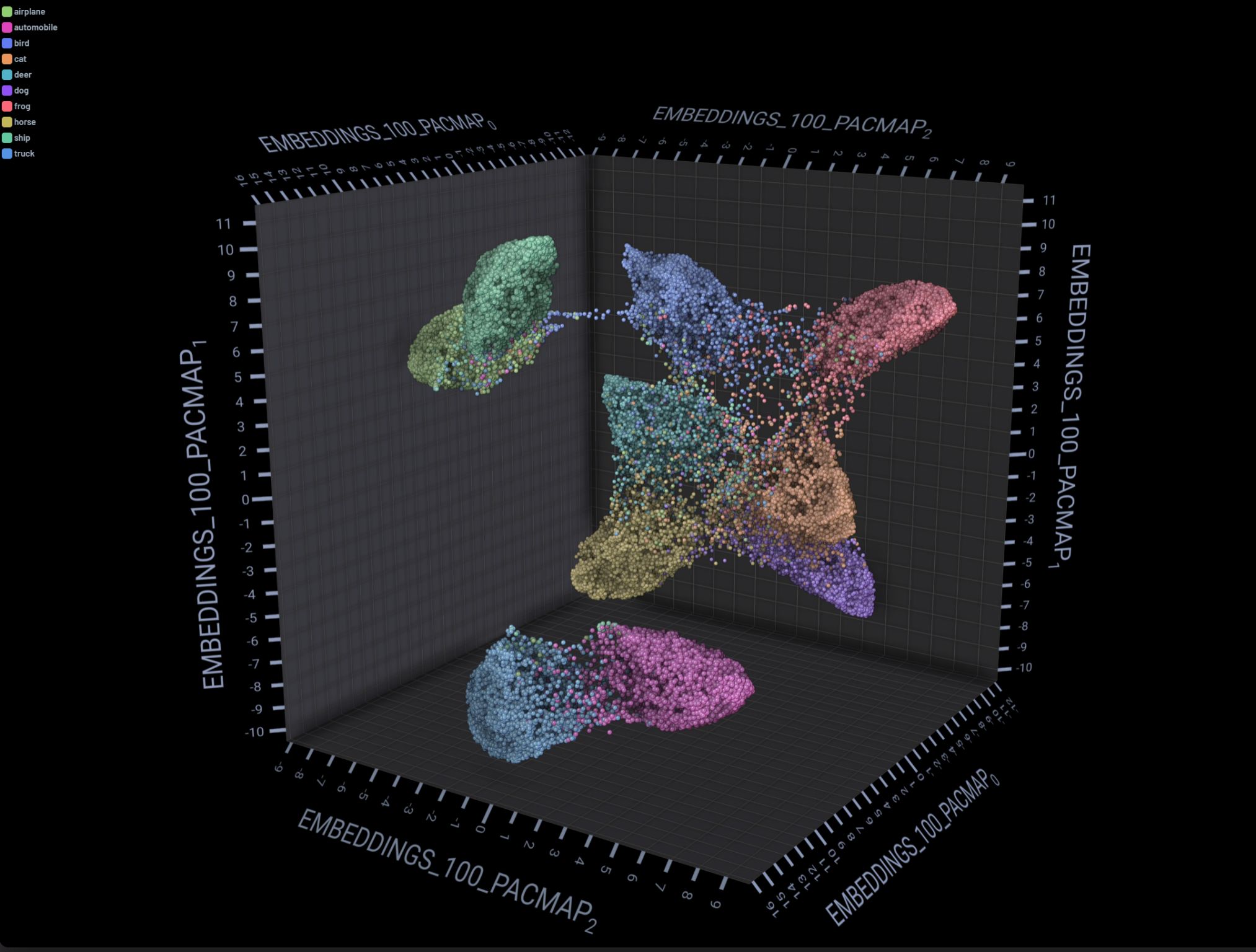

Quand un modèle de langage analyse une situation, il ne "lit" pas les faits un par un. Il les projette dans un espace mathématique à des milliers de dimensions (4096 pour le modèle E5 de Mistral (super modèle)). Chaque concept, chaque donnée, chaque implication devient un point dans cet espace. Là où l'officier voit une "capacité portuaire limitée" et en déduit une "contrainte logistique", le LLM perçoit simultanément les corrélations entre cette capacité, les cycles de marées, l'état des routes, l'instabilité politique locale et l'historique des prix du carburant.

L'analogie aussi a changé de nature. L'humain raisonne par ressemblance visible : "C'est comme en 1991." La machine identifie des similitudes structurelles entre des faits que nous n'associerions jamais, parce qu'ils ne sont proches que dans la 2457ᵉ dimension de son analyse. Et puis il y a la vitesse. Le processus humain est lent, sujet à la fatigue, aux biais, au filtrage arbitraire. L'IA traite la totalité des données sans s'épuiser. Ce que nos équipes mettent des semaines à produire, elle le fait en millisecondes.

Alors, cette méthode est-elle obsolète ?

Pas tout de suite. En ayant conscience de ses limites, le triptyque Fait-Déduction-Conclusion reste un excellent outil pour une validation de l’intuition. Mais pour la compétition réelle, dans un monde en pleine accélération, notre biologie ne peut pas lutter : on ne peut traiter que sept à neuf variables à la fois. Notre logique reste désespérément linéaire. L'avenir ne s’inscrit pas dans une rivalité avec la machine, mais dans une complémentarité, selon une logique qui veut qu’il ne faut jamais faire ce que quelqu’un d’autre peut faire pour vous, beaucoup plus vite et mieux.

La vraie compétence de demain ? Savoir orchestrer cette intelligence, pas la concurrencer.

L'IA a-t-elle déjà gagné la bataille du savoir ? Une révolution dans la fabrique de la connaissance

Le chemin traditionnel vers le savoir, symbolisé par le triptyque « Faits – Déductions – Conclusions », est souvent perçu comme une démarche laborieuse, une « pesanteur » inutile. Pourtant, cette structure n'est pas un fardeau, mais un catalyseur essentiel. Elle est la charpente qui permet la transformation des intuitions brutes en démonstrations rationnelles et argumentées. Son usage optimal réside dans une application a posteriori : elle sert à valider, structurer et justifier des choix déjà pressentis ou opérés. L'erreur humaine courante est de vouloir l'utiliser a priori, pour générer l'idée ou guider la conception d'un plan ; une approche qui mène rapidement à l’impasse et à la stérilité créative pour l'esprit humain.

Ce processus classique repose sur les trois piliers fondamentaux de la création du savoir :

-

L'induction : La capacité à repérer des faits répétitifs ou des motifs récurrents dans le réel pour en extraire une règle générale ou une hypothèse.

-

La déduction : L'acte de confronter cette règle établie ou cette hypothèse à un fait nouveau ou spécifique pour en tirer une conséquence logique.

-

L'analogie : Le point essentiel, trop souvent ignoré ou sous-estimé, qui est l'établissement de liens entre des domaines a priori distincts. Sans cette mise en relation, un fait isolé ne produit jamais de déduction significative.

Le syllogisme, archétype de l'art déductif, illustre parfaitement cette élégance rigoureuse : tous les ports à quai unique créent des goulots d'étranglement. Le port de Martyria n'a qu'un seul quai. Donc, ce port sera un problème logistique.Les Limites de la Logique Humaine à l'Ère des Données Massives

Aussi élégant et rigoureux soit-il, ce raisonnement est terriblement limité face à la complexité du monde moderne. Il exige de l'humain une double prouesse cognitive :

-

L'identification préalable de la bonne règle parmi des milliers de principes potentiels.

-

Le repérage des « bons » faits pertinents dans un océan de données souvent bruyantes ou contradictoires.

Nous sommes contraints de créer du savoir à la bougie, en reliant péniblement deux points dans l'obscurité d'un univers informationnel gigantesque. Notre processus est lent, sujet à la fatigue, déformé par des biais cognitifs et dépendant d'un filtrage arbitraire des informations. Biologiquement, notre capacité de traitement est limitée à sept à neuf variables à la fois. Notre logique est désespérément linéaire.Le LLM : L'Ascension dans l'Espace de la Connaissance Multidimensionnelle

Le Large Language Model (LLM) ne joue pas dans la même cour que l'esprit humain ; il évolue littéralement dans une autre dimension.

Quand un modèle de langage analyse une situation, il n'opère pas une « lecture » séquentielle des faits. Il les projette dans un espace mathématique à des milliers de dimensions. Pour le modèle E5 de Mistral, par exemple, cela se traduit par 4096 dimensions. Dans cet hyper-espace, chaque concept, chaque donnée, chaque implication, chaque lien potentiel devient un point vectoriel.

Là où l'officier de logistique identifie une "capacité portuaire limitée" et en déduit une "contrainte logistique", le LLM effectue une lecture synthétique et perçoit simultanément les corrélations profondes entre cette capacité, les cycles de marées précis, l'état actuel et prévu des infrastructures routières, l'instabilité politique locale mesurée par des indicateurs précis, et l'historique des prix du carburant agrégé sur une décennie. Il n'additionne pas les variables ; il les intègre dans un modèle de cohérence globale.Une Nouvelle Nature de l'Analogie

L'analogie elle-même a fondamentalement changé de nature. L'humain raisonne par ressemblance visible et superficielle : « Cette crise, c'est comme la situation en 1991 », en se basant sur des similarités contextuelles macroscopiques. La machine, elle, identifie des similitudes structurelles profondes entre des faits ou des événements que l'esprit humain n'associerait jamais, parce qu'ils ne sont proches que dans la 2457ᵉ dimension de son analyse vectorielle. Le savoir n'est plus une ligne reliant deux points évidents, mais une topologie complexe dans un espace de possibilités illimité.

Ajoutez à cela la vitesse stupéfiante de l'IA : elle traite la totalité des données disponibles sans s'épuiser ni filtrer arbitrairement. Ce que des équipes d'analystes mettent des semaines à produire et à valider, le modèle le génère en millisecondes.Conclusion : Complémentarité et Nouvelle Compétence

Cette méthode humaine, le triptyque Fait-Déduction-Conclusion, est-elle obsolète ? Pas dans l'immédiat. En ayant une conscience aiguë de ses limites, elle demeure un excellent outil pour la validation, la communication et la structuration d'une intuition. Elle permet de traduire la complexité générée par l'IA en un récit humain compréhensible et actionnable.

Mais pour la compétition réelle, pour la création de connaissance stratégique dans un monde en pleine accélération, notre biologie ne peut pas lutter. L'avenir ne s'inscrit pas dans une rivalité stérile avec la machine, mais dans une complémentarité stratégique. La logique à adopter est simple et impitoyable : il ne faut jamais faire ce que quelqu’un d’autre (ou quelque chose d’autre) peut faire pour vous, beaucoup plus vite et beaucoup mieux.

La vraie compétence de demain n'est plus la production artisanale du savoir, mais la maîtrise de l'orchestration de cette intelligence artificielle. Il s'agit de savoir poser les bonnes questions, interpréter les résultats multidimensionnels et les intégrer dans des stratégies humaines.